什么是LLM大语言模型?

嗨,你好呀,我是猿java

大型语言模型(LLM)是深度学习算法,能够利用非常大的数据集进行识别、总结、翻译、预测和生成内容,这篇文章我们聊聊什么是大语言模型。

什么是大型语言模型?

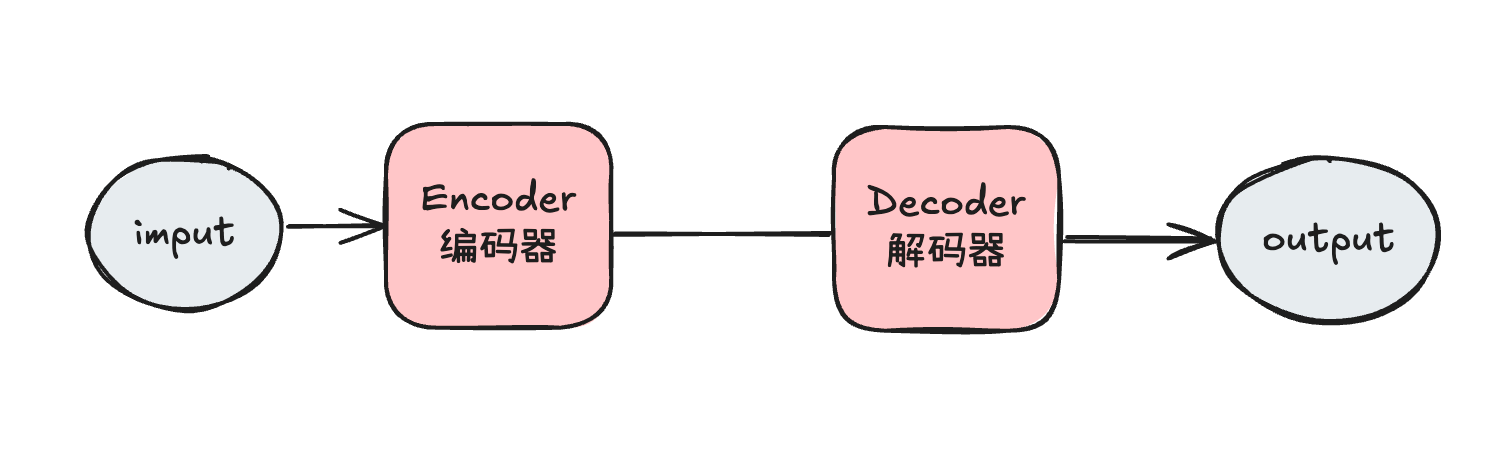

大型语言模型(Large Language Models,LLMs)是非常大的深度学习模型,预先在海量数据上进行训练,其底层的 Transformer(在 2017年由谷歌在论文“Attention Is All You Need”中首次提出)是一组神经网络,包括具有自注意力能力的编码器和解码器。编码器和解码器从文本序列中提取意义,并理解其中单词和短语之间的关系。

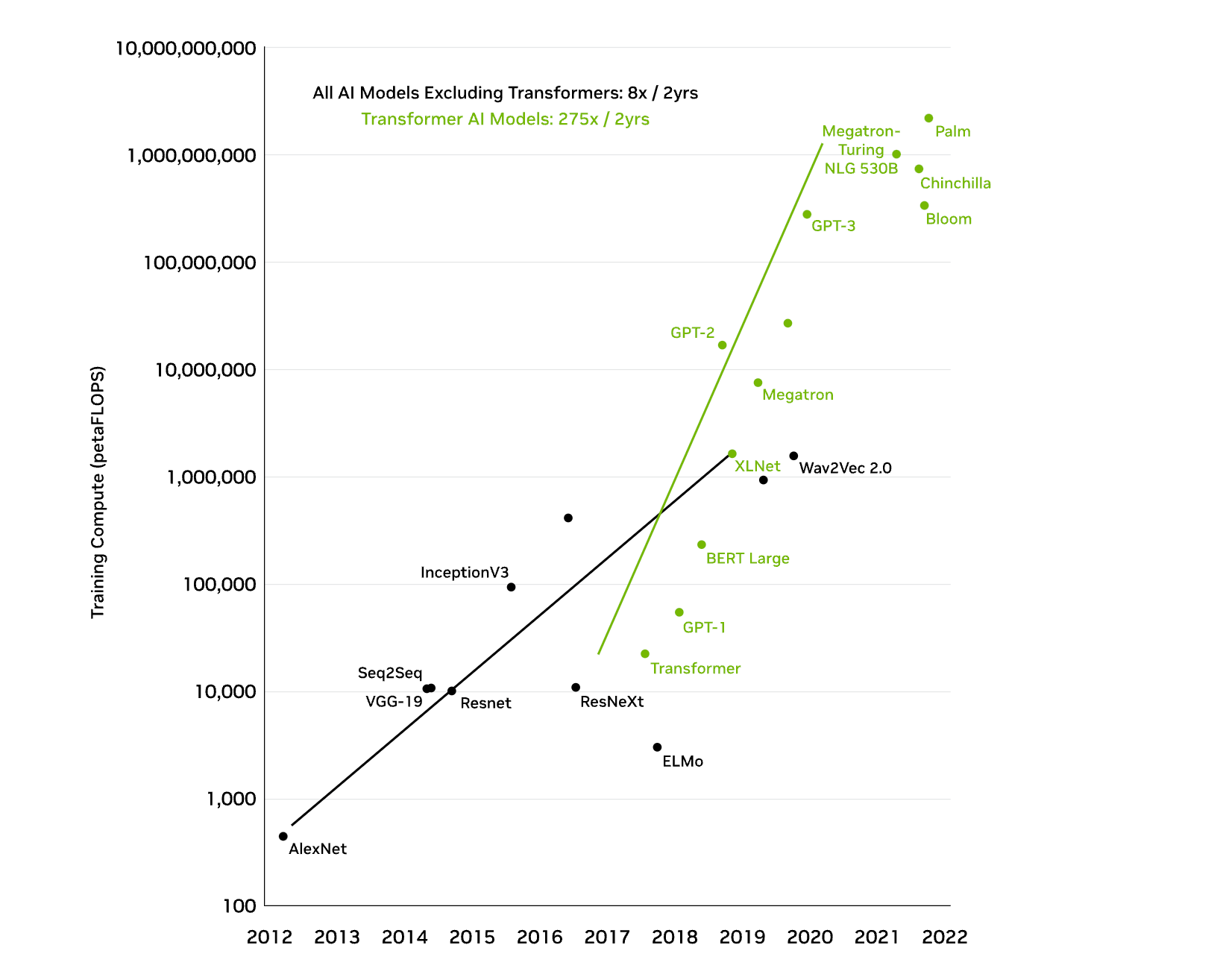

Transformer LLMs能够进行无监督训练,更准确地说是自学习。通过这个过程,Transformer学习理解基本的语法、语言和知识。与早期的递归神经网络(RNN)需要顺序处理输入不同,Transformer能够并行处理整个序列,这允许数据科学家使用 GPU来训练基于 Transformer的LLM,大大减少了训练时间。

Transformer神经网络架构允许使用非常大的模型,通常具有数千亿个参数。这种大规模的模型可以摄取海量数据,通常来自互联网,也包括像 Common Crawl这样的来源,后者包括超过 500亿个网页,以及维基百科,大约有 5700万页。

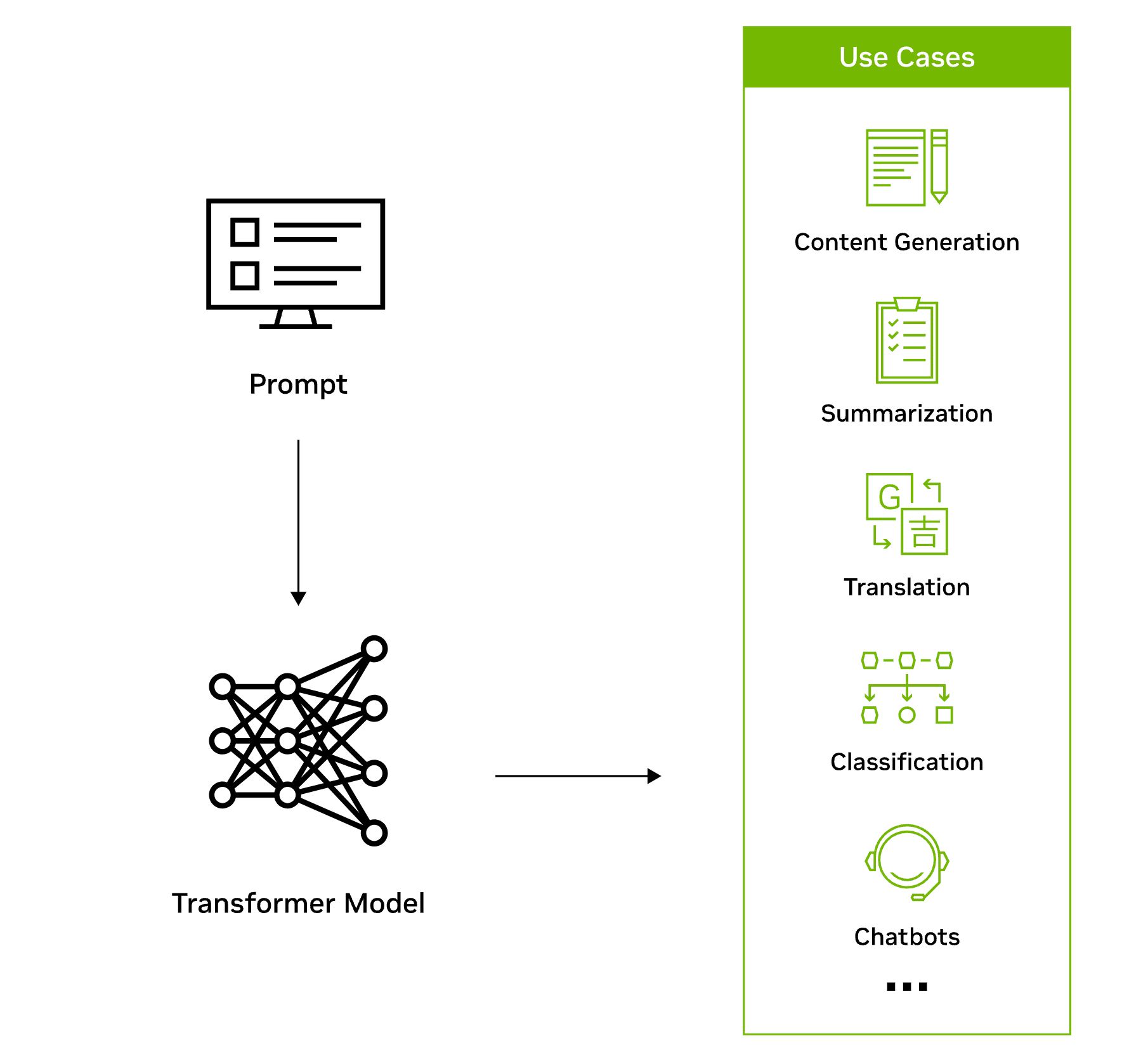

Transformer模型工作流程如下图:

Transformer之所以非常适合用于大型语言模型,主要有两个关键创新:位置编码和自注意力。

位置编码(positional encodings):是指嵌入输入在序列中出现的顺序。本质上,借助位置编码,单词可以不按顺序输入到神经网络中,而不是逐个按顺序输入。

自注意力(self-attention):在处理输入数据时为每个部分分配一个权重,这个权重表示该输入在整个输入中的重要性。换句话说,模型不需要对所有输入给予同等的注意,而是可以专注于实际上重要的部分。随着模型筛选和分析海量数据,这种关于神经网络需要关注的输入部分的表示会逐渐学习。

这两种技术结合在一起,使得可以分析在长距离、非顺序的情况下,各个元素是如何微妙地影响和相互关联的。这种非顺序处理数据的能力能够把复杂问题分解成多个小的、同时进行的计算。自然地,GPU在并行解决这些类型的问题上非常适合,可以大规模处理大型未标注数据集和巨大的Transformer网络。

LLM如何工作?

LLMs工作机制的一个关键因素是它们表示单词的方式,早期的机器学习形式使用一个数值表来表示每个单词,但这种表示形式无法识别单词之间的关系,比如具有相似含义的单词,这个限制通过使用多维向量(通常称为词嵌入)来表示单词得以克服,使得具有相似上下文含义或其他关系的单词在向量空间中彼此接近。

使用词嵌入,Transformer可以通过编码器将文本预处理为数值表示,并理解具有相似含义的单词和短语的上下文以及单词之间的其他关系,比如词性。然后,LLMs可以通过解码器应用这种语言知识生成独特的输出 其编码器-解码器语言模型的结构如下图:

有几类大型语言模型适用于不同类型的用例:

- 仅编码器:这些模型通常适用于能够理解语言的任务,如分类和情感分析。仅编码器模型的例子包括BERT(Bidirectional Encoder Representations from Transformers)。

- 仅解码器:这类模型在生成语言和内容方面非常出色。部分用例包括故事写作和博客生成。仅解码器架构的例子包括GPT-3(Generative Pretrained Transformer 3)。

- 编码器-解码器:这些模型结合了Transformer架构的编码器和解码器组件,以便理解和生成内容。在翻译和总结等用例中,这种架构表现尤为出色。编码器-解码器架构的例子包括T5(Text-to-Text Transformer)。

LLM的实例

2020年6月,OpenAI发布了GPT-3,这是一种拥有 1750亿参数的模型,能够根据简短的书面提示生成文本和代码。

2021年,英伟达和微软开发了 Megatron-Turing自然语言生成 530B,这是世界上最大之一的阅读理解和自然语言推理模型,拥有5300亿参数。

随着 LLM规模的扩大,它们的功能也是如此,广义上,文本内容的 LLM用例可以分为以下几类:

生成(如故事写作、营销内容创建)

总结(如法律释义、会议记录总结)

翻译(如语言之间、文本到代码)

分类(如毒性分类、情感分析)

聊天机器人(如开放域问答、虚拟助手)

全球各地的企业开始利用LLM来解锁新可能性:

- 医学研究人员在医疗保健中训练大型语言模型,使用教科书、研究论文和患者电子健康记录的数据集来完成诸如蛋白质结构预测等任务,以发现疾病中的模式并预测结果。

- 零售商可以利用LLM通过动态聊天机器人为客户提供卓越的客户体验。

- 开发人员可以利用LLM编写软件并教导机器人执行物理任务。

- 财务顾问可以使用LLM总结收益电话并创建重要会议的记录。

- 营销人员可以训练LLM将客户反馈和请求组织成集群,或者根据产品描述将产品分成类别。

大型语言模型仍处于早期阶段,但它们的前景十分广阔;一个具备零样本学习能力的单一模型可以通过及时理解和生成类人思维来解决几乎所有想象得到的问题。其应用案例涵盖每家公司、每次商务交易和每个行业,创造巨大的价值创作机会。

LLM的挑战

开发和维持大型语言模型需要的巨额资本投资、大数据集、技术专长以及大规模计算基础设施对大多数企业来说是一个进入门槛。训练 Transformer模型所需的计算资源如下图:

LLM的应用场景

LLMs有许多实际应用:

- 文案写作:除了GPT-3和ChatGPT,Claude、Llama 2、Cohere Command和Jurassic都可以写原创文案。AI21 Wordspice可以建议改变原句以改善风格和语气。

- 知识库回答:通常称为知识密集型自然语言处理(KI-NLP),该技术指的是LLMs可以从数字档案中回答特定问题。一个例子是AI21 Studio playground能够回答一般知识问题。

- 文本分类:通过聚类,LLMs可以对具有相似含义或情感的文本进行分类。用途包括测量客户情感、确定文本之间的关系和文档搜索。

- 代码生成:LLMs在从自然语言提示生成代码方面表现出色。Amazon Q Developer可以用Python、JavaScript、Ruby和其他几种编程语言编写代码。其他编码应用包括创建SQL查询、编写shell命令和网站设计。

- 文本生成:类似于代码生成,文本生成可以完成不完整的句子、编写产品文档,或者像Alexa Create那样写一篇短儿童故事。

LLM的未来

像 ChatGPT、Claude 2和 Llama 2这样的大型语言模型的出现,能够回答问题和生成文本,指向了未来的激动人心的可能性。这些LLMs的迅速成功展示了对类机器人LLMs的浓厚兴趣,这些LLMs在某些情况下模仿甚至超越了人类大脑。以下是一些关于LLMs未来的思考:

- 增强的能力:尽管现有技术令人印象深刻,但并不完美,LLMs并非万无一失。然而,随着开发者学习如何提高其性能,同时减少偏差和消除错误答案,新的版本将具备更高的准确性和增强的能力。

- 视听训练:虽然大多数LLMs使用文本进行训练,但一些已经开始使用视频和音频输入进行训练。这种训练形式应能加快模型开发,并在使用LLMs进行自动驾驶汽车方面开辟新的可能性。

- 工作场所变革:LLMs是一个颠覆性因素,将改变工作场所。LLMs可能会像机器人对重复制造任务那样减少单调和重复的任务。可能性包括重复的文书工作、客户服务聊天机器人和简单的自动文案写作。

- 对话式AI:LLMs无疑会提高自动化虚拟助手如Alexa、Google Assistant和Siri的性能。它们将更好地解释用户意图并响应复杂的命令。

总结

大型语言模型(LLMs)是非常强大的AI工具,像是ChatGPT这类应用就是它们的产物。简单来说,LLMs通过在海量数据上进行训练,学会理解和生成自然语言,这些模型可以用来回答问题、翻译语言、写文章,甚至生成代码。它们的核心技术是Transformer架构,这让它们可以快速处理信息并找出语言中的模式。随着技术的发展,LLMs正在让机器更接近人类的语言理解能力。

交流学习

最后,把猿哥的座右铭送给你:投资自己才是最大的财富。 如果你觉得文章有帮助,请帮忙转发给更多的好友,或关注公众号:猿java,持续输出硬核文章。